L’intelligence artificielle a connu des avancées spectaculaires ces dernières années, notamment grâce aux Large Language Models (LLMs). Cependant, l’une des principales limites de ces modèles réside dans leur difficulté à raisonner de manière explicite et structurée en planifiant différentes étapes dans leur raisonnement.

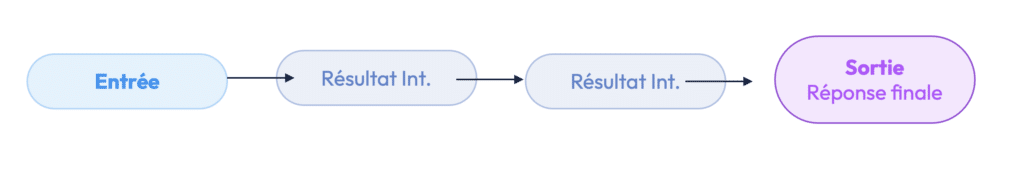

Pour résoudre ce challenge, l’approche Chain of Thought (CoT) permet aux modèles d’IA de décomposer les problèmes complexes en une suite de raisonnements intermédiaires. C’est un sujet que j’aborde dans un des 8 webinars de l’IAcadémie !

Le Chain of Thought a été introduit en 2022 par des chercheurs de Google dans leur article “Chain of Thought Prompting Elicits Reasoning in Large Language Models”.

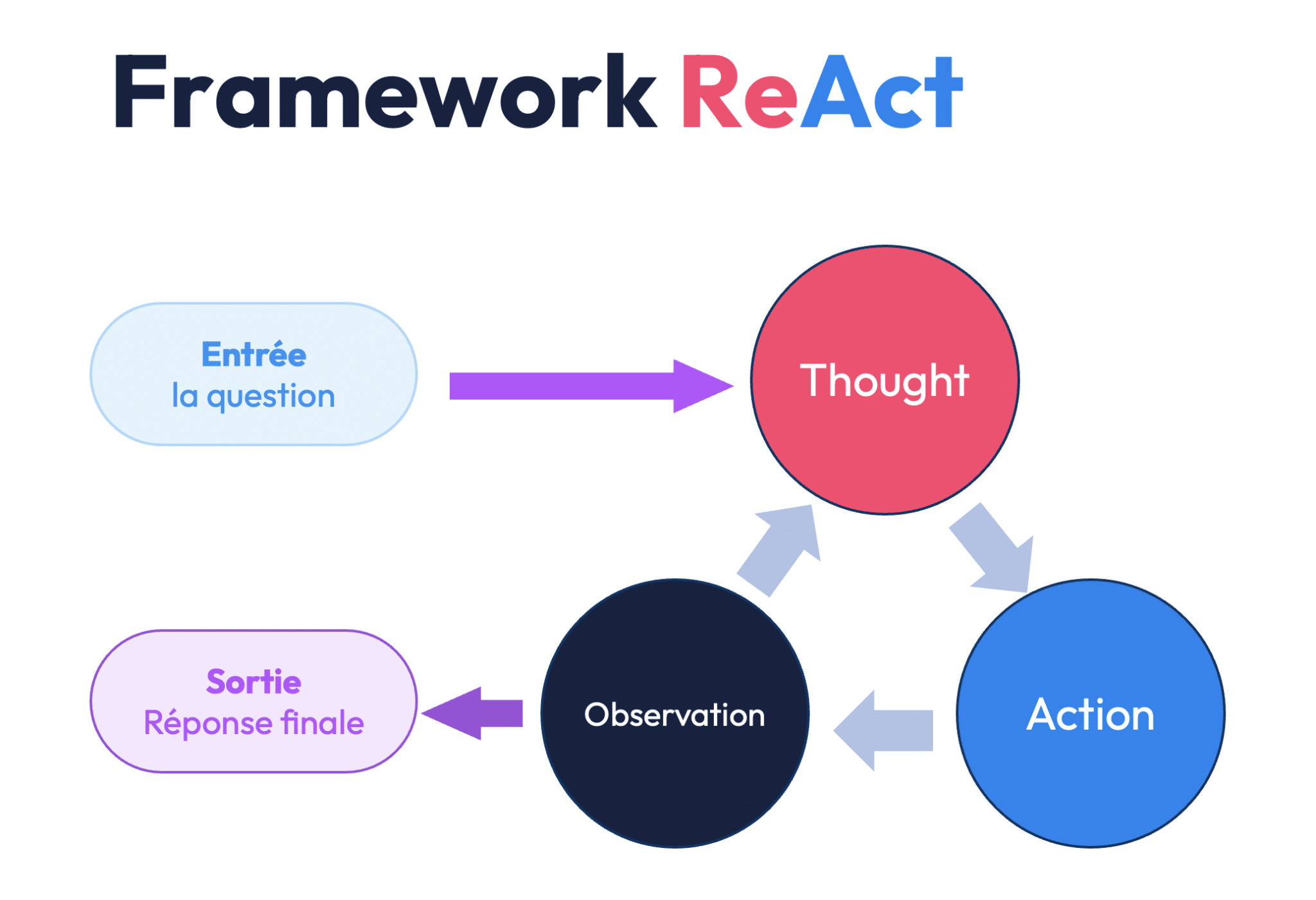

Le CoT est une des techniques qui a donné naissance aux agents dit « Agentic », dotés de cette capacité à planifier des actions pour résoudre un problème : en un sens les agents agentiques sont plus autonomes que les agents IA traditionnels. Pour mieux comprendre le fonctionnement des agents et les caractéristiques des agents agentiques, je vous invite à lire cet article dédié à ce sujet.

–

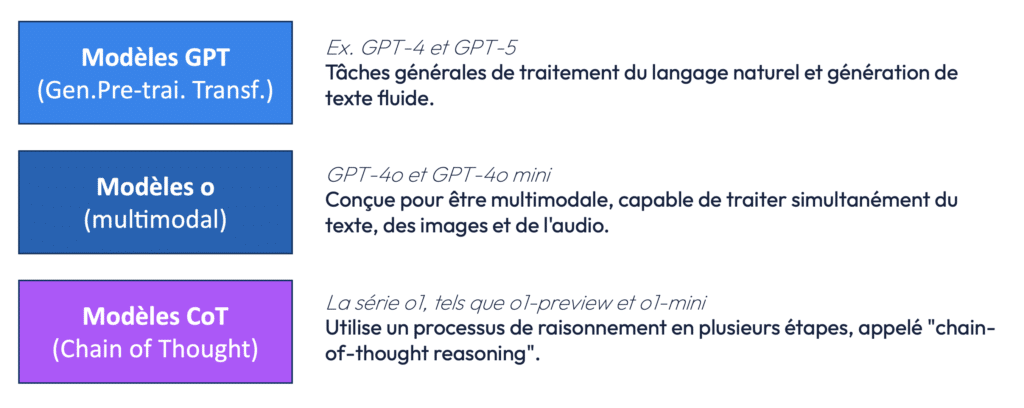

A noter qu’on retrouve le concept d’Agentic Agents et de CoT dans la manière dont OpenAI a structuré son offre de modèles IA, qui peut être simplifiée en trois grandes catégories – la dernière étant dédiée au CoT :

Les modèles GPT (Generative Pre-trained Transformer)

Ce sont les modèles que nous connaissons bien, comme GPT-4 ou GPT-5. Leur rôle principal est de traiter et de générer du texte de manière fluide. Ils sont excellents pour la rédaction, la traduction, le résumé de documents, etc.

Les modèles multimodaux (série “O”)

Contrairement aux GPT traditionnels, ces modèles sont capables de traiter différents types de données en entrée : texte, images, audio, et plus encore. Cette capacité les rend plus polyvalents et performants dans des tâches variées.

Les modèles CoT (série “O1”)

Ces modèles introduisent une nouvelle forme d’architecture basée sur le raisonnement en utilisant l’approche CoT. Ils sont plus lents pour répondre mais sont aussi capable de mieux approcher et répondre aux problèmes complexes.

Qu’est ce que le Chain of Thought ?

Le Chain of Thought est inspiré des méthodes pédagogiques où un enseignant guide un élève en détaillant chaque étape d’un raisonnement. Plutôt que de fournir directement une réponse, l’IA est invitée à suivre une séquence logique d’étapes intermédiaires. Cela permet d’améliorer la précision et la transparence du raisonnement.

Prenons un exemple simple de mathématiques !

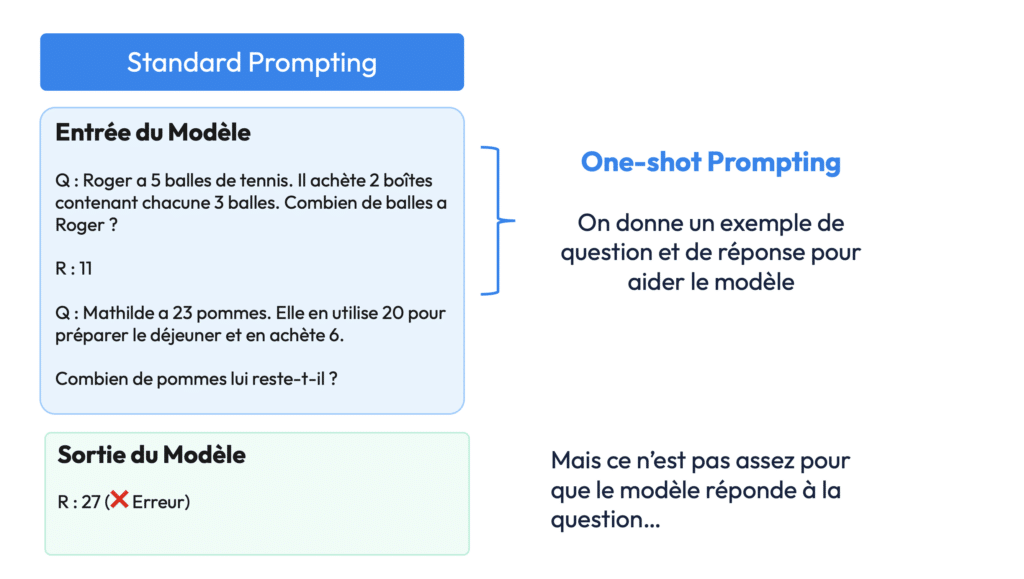

Prompting standard

“Mathilde a 23 pommes. Elle utilise 20 pommes pour préparer le déjeuner et en achète 6. Combien lui en reste-t-il ?”

Si l’IA tente une réponse directe sans raisonnement, elle risque de se tromper.

La bonne approche consiste à lui fournir un shot, via du one-shot prompting (un shot étant un exemple).

- Question : “Roger a 5 balles de tennis. Il achète 2 boîtes contenant chacune 3 balles. Combien de balles a-t-il au total ?”

- Réponse : 11

Cependant en lui fournissant juste cet exemple, sans lui détailler le raisonnement de “chaine de pensées”, l’IA ne comprendra pas la manière de répondre à ce type de question et fera des erreurs quand elle sera confronté à des questions similaires.

Ci-dessous l’IA se trompe et répond 27 à la question sur les pommes de Mathilde.

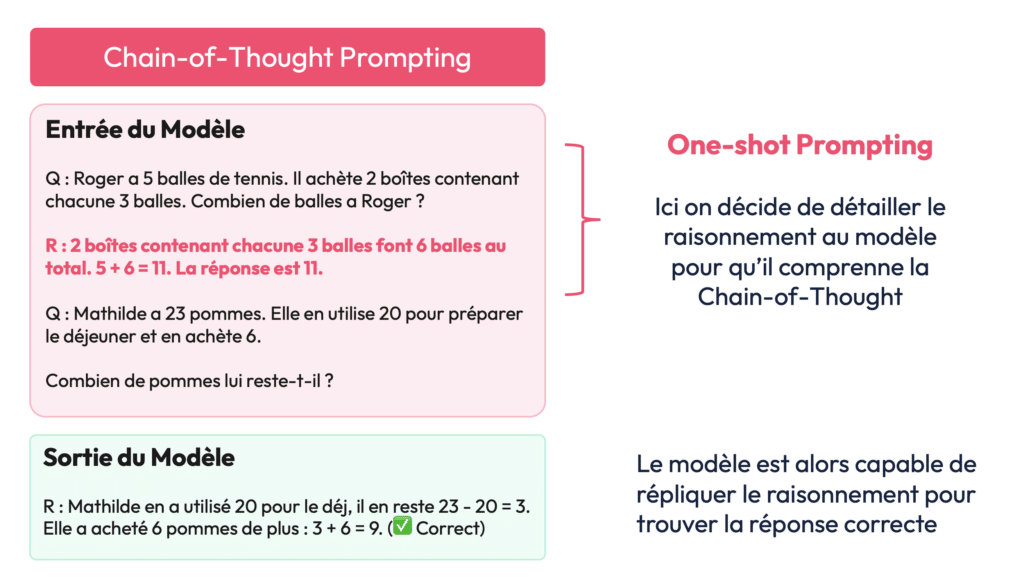

CoT Prompting

Dans le cas du Chain of Thought prompting, on explique à l’IA les différentes étapes du raisonnement :

👉 « Roger a 5 balles. Il achète 2 boîtes contenant 3 balles chacune. Donc 2 × 3 = 6. Ensuite, 5 + 6 = 11. La réponse est 11. »

Une fois que l’IA a compris ce raisonnement, elle est plus apte à répondre correctement à un problème similaire :

Problème posé :

“Mathilde a 23 pommes. Elle utilise 20 pommes pour préparer le déjeuner et en achète 6. Combien lui en reste-t-il ?”

Avec le Chain of Thought, l’IA suit cette logique :

- Mathilde commence avec 23 pommes

- Elle en utilise 20, donc il lui en reste 3

- Elle en achète 6, donc 3 + 6 = 9

- Réponse finale : 9 pommes

Sans cette structure, le modèle pourrait donner une réponse erronée.

Aujourd’hui, le Chain of Thought est utilisé dans de nombreux domaines, notamment :

- Mathématiques et logique : résolution d’équations complexes, raisonnement algorithmique.

- Assistance à la prise de décision : les agents IA peuvent structurer leurs réponses pour clarifier leur raisonnement.

- Agents conversationnels avancés : amélioration de la compréhension et de la cohérence des interactions.

Les agents IA agentiques (c’est-à-dire des IA capables de planifier et d’exécuter des tâches de manière autonome) exploitent le CoT pour rendre leurs décisions plus explicites et vérifiables. Cette approche est cruciale pour améliorer la fiabilité et la transparence des modèles d’IA appliqués à des tâches critiques comme la médecine, la finance ou l’automatisation industrielle.

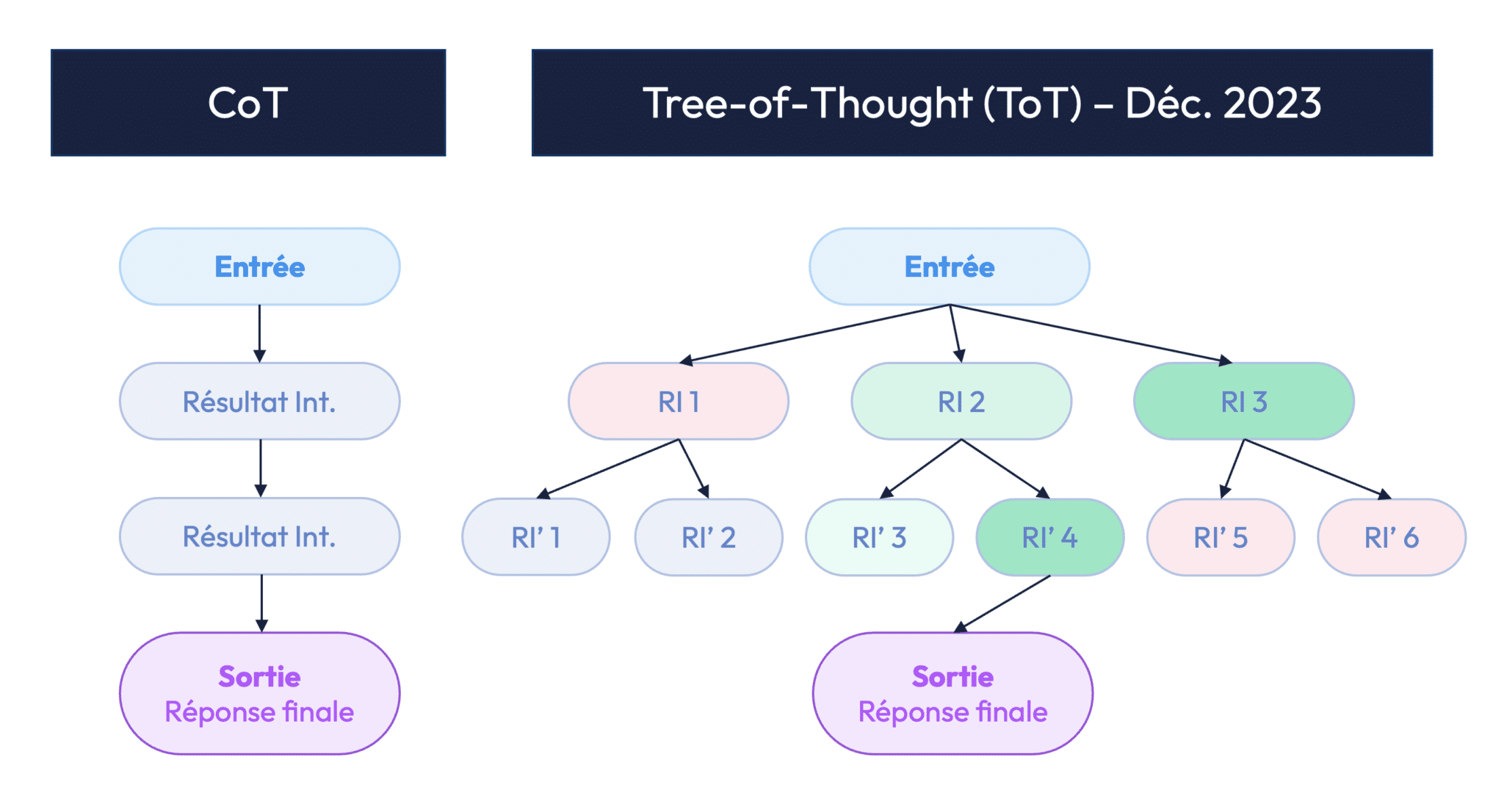

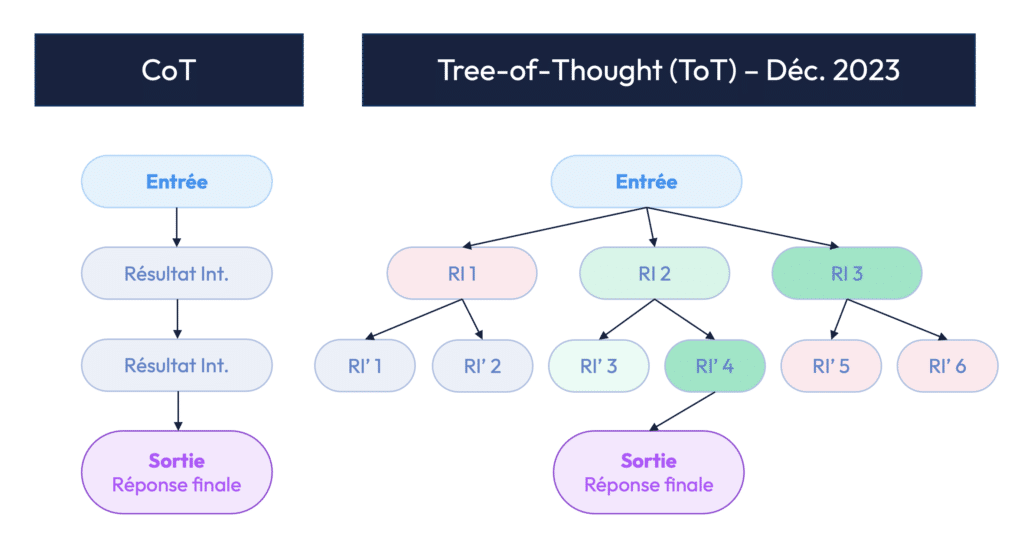

Tree of Thought : une approche plus avancée

Introduit en 2023 par Microsoft Research, le Tree of Thought (ToT) généralise le CoT en permettant à l’IA d’explorer plusieurs chemins de raisonnement en parallèle. Plutôt que de suivre une seule ligne logique, le modèle peut évaluer différentes options à chaque étape, comme le ferait un humain lorsqu’il réfléchit à plusieurs scénarios avant de prendre une décision.

Le ToT s’inspire des algorithmes de recherche heuristique, comme ceux utilisés dans l’intelligence artificielle classique pour les jeux d’échecs ou de go. Concrètement, il permet :

- Une meilleure exploration des solutions : au lieu de suivre un seul raisonnement, l’IA peut envisager plusieurs alternatives avant de choisir la meilleure.

- Un raisonnement itératif et auto-corrigé : l’agent peut revenir en arrière et réévaluer certaines étapes si nécessaire.

- Une adaptation aux tâches ouvertes : utile pour la programmation, la résolution de problèmes complexes ou la planification stratégique.

Application des ToT dans les agents IA

Les agents IA modernes combinent souvent Chain of Thought et Tree of Thought pour améliorer leur capacité de prise de décision. Par exemple, dans le cadre d’un agent de support client, un ToT permettrait d’évaluer plusieurs réponses possibles et d’optimiser celle qui maximise la satisfaction utilisateur. Dans le cadre de la génération de code, un modèle peut tester plusieurs implémentations et choisir la plus efficace.

Le ToT est donc une avancée majeure pour rendre les agents plus autonomes et performants, les rapprochant encore plus de véritables intelligences capables de raisonnement complexe.

Si ces sujets vous intéressent, je vous invite à regarder la série de webinar IAcadémie2 sur le vaste sujet des agents autonome ! C’est gratuit.